はじめに

私たちは普段、文字だけでなく画像や音声、映像といった様々な情報を同時に受け取って理解しています。それと同じように、AIも「複数のモダリティ(形式)」を理解・活用できるように進化しつつあります。これが“マルチモーダルAI”の世界です。

OpenAIのChatGPTも、o4-miniなどのモデルによってこの領域に大きな進展を見せています。今回は、マルチモーダルAIの概要から、ChatGPTで何ができるのか、今後の可能性まで詳しく解説します。

マルチモーダルAIとは?

「マルチモーダル(multi-modal)」とは、“複数の種類の情報”を意味します。AIの分野では、テキスト、画像、音声、動画、センサーデータなど、異なる情報形式を統合的に処理する技術を指します。

従来のAIは、文章だけを扱う、画像だけを分類する、音声だけを認識する──といった“単一モーダル”のアプローチが主流でした。これに対し、マルチモーダルAIは複数のモダリティを統合し、相互に関連づけた判断や生成ができるのが特徴です。

ChatGPTでできるマルチモーダル処理

ChatGPTのo4-miniモデルでは、以下のようなマルチモーダル機能が実装されています:

1. 画像の理解・要約

ユーザーがアップロードした画像の内容をAIが読み取り、説明・分析・要約を行えます。例としては:

– 写真の中の物体や状況の説明

– スクリーンショットからのエラー解析

– 手書きメモやホワイトボードの内容要約

2. 画像とテキストの統合推論

テキストと画像を組み合わせて、より深い推論が可能です。

– チャートや図表の説明+その解釈

– 写真を見せて「この状況に合うアドバイスは?」と尋ねる

– 設計図を見ながら改善点を尋ねる

3. 書き出し・生成機能との連携

画像に関する説明文、キャプション、SNS投稿文などを自動生成。創作系にも活躍の場があります。

活用シーンの具体例

教育:視覚教材の理解支援

画像付きの問題に対して解説を付けたり、グラフを読み解く力を育むツールとして活用されています。

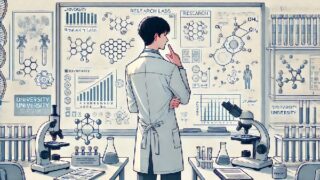

医療:画像診断支援

医療画像(例:レントゲン、CT画像)をAIが説明・分類し、医師の判断を補助する研究が進んでいます。

クリエイティブ分野:画像×言語の共同制作

生成AIと組み合わせて、画像に合ったストーリーやポエムを作ったり、ビジュアルに基づくアイデア出しが可能です。

マーケティング:投稿生成や資料作成

製品画像に合わせてキャッチコピーや説明文を作るなど、画像→文章変換が効率化されます。

ChatGPTがマルチモーダルで優れている点

– 直感的な対話:画像を貼るだけで、「この図は何?」と尋ねられる

– 背景知識との統合:画像の内容と世界知識を結びつけた深い考察が可能

– 高度な説明力:単に「何が写っているか」ではなく、「なぜそう見えるか」まで説明できる

技術的には何がすごいのか?

ChatGPTにおけるマルチモーダル処理では、以下の技術が使われています:

– Vision Transformerなどの視覚認識モジュール

– クロスアテンションによるテキストと画像の結合処理

– 統合学習データセットによる事前学習(例:画像+説明文のペアなど)

これにより、視覚と文脈の“架け橋”となるようなモデルが実現されています。

今後の展望

将来的には、以下のような進化が期待されます:

– 動画+音声+テキストの同時処理

– AR/VRとの連携で視覚的体験と対話の融合

– 視覚障害者支援への応用(現実世界を言語で説明)

また、リアルタイムカメラやスマートグラスと接続することで、常時「目の代わり」を務めるAIパートナーも現れるかもしれません。

まとめ

マルチモーダルAIは、AIにとっての“人間らしさ”に近づくための大きな一歩です。

ChatGPTは、ただの文章応答AIではなく、視覚・文脈・意味を統合的に扱える“新しい知性”として進化しています。これからのAIは、見る・考える・伝える──そのすべてを同時にこなす時代へと入っていくのです。

コメント